AIを使っていると、「社内システムのデータを参照して回答してほしい」「ローカルにある資料を踏まえて分析してほしい」と思うことが少なくありません。

ですが、社内データなどを外部AIサービスに送信することは、セキュリティ上難しいです。

クラウドにさえ持っていけないことも結構あります。

そんな要求に応えるのが MCP (Modex Context Protocol) です。

MCPは、AIクライアントと外部ツール・データソースをつなぐための共通プロトコルで、

ローカル環境でも安全にAI連携を構築できる仕組みを提供します。

今回はOllamaとMCPを使って、AIからローカルデータを参照できる環境を、完全ローカルで構築してみようと思います。

Ollamaのインストール

最初にOllamaのインストールですが、こちらの記事を参考にしてもらえればと思います。

導入は簡単で下記の手順になります。

- 公式サイト(https://ollama.com/)からインストーラをダウンロード

- インストール

- モデルのダウンロード

Go言語のインストール

今回、MCPを構築するためにMCPHost(https://github.com/mark3labs/mcphost)というライブラリを使用するのですが、こちらがGo言語前提のためインストールを行います。

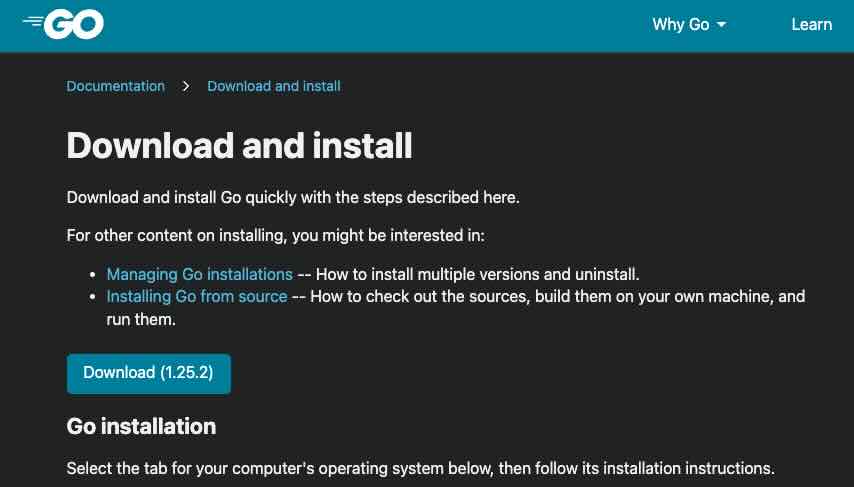

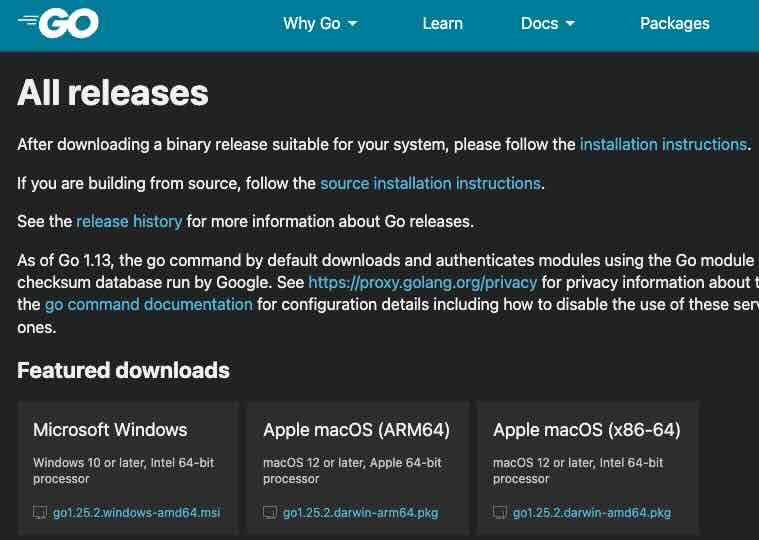

公式サイトのダウンロードページ(https://go.dev/doc/install)からDownloadをクリックし、

環境にあったインストーラをダウンロードします。

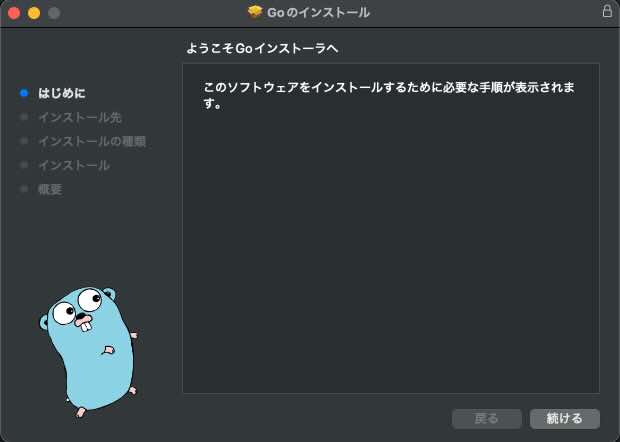

ダウンロードしたインストーラを実行し、手順に沿ってインストールします。

MCPHostのインストール

続いてMCPHost(https://github.com/mark3labs/mcphost)のインストールです。

こちらは、先程インストールしたGoコマンドを使ってインストールするようになります。

ターミナルで下記のインストールコマンドを実行します。

go install github.com/mark3labs/mcphost@latestjson設定

MCPHostの設定ファイルを作成します。

モデルやAIPキー、各MCPサーバーの設定などを行うためのファイルです。

プロジェクトディレクトリに「.mcphost.json」の名前でファイルを作成します。

※このファイル名はデフォルトで読み取ってくれるファイル名です。別のファイル名にすることも可能です。

今回はローカルファイルを参照するためのMCPサーバーの設定を行ってみます。

詳しい設定方法はMCPHostのGithub(https://github.com/mark3labs/mcphost)を参照してみてください。

{

"mcpServers": {

"file-system": {

"command": "npx",

"args": [

"-y",

"@modelcontextprotocol/server-filesystem",

"{参照ディレクトリのパス}"

]

}

}

}Windows環境の場合、パスのセパレータは「 \ 」ではなく「 \\ 」と二重にする必要があるので注意が必要です。

MCPHostの起動

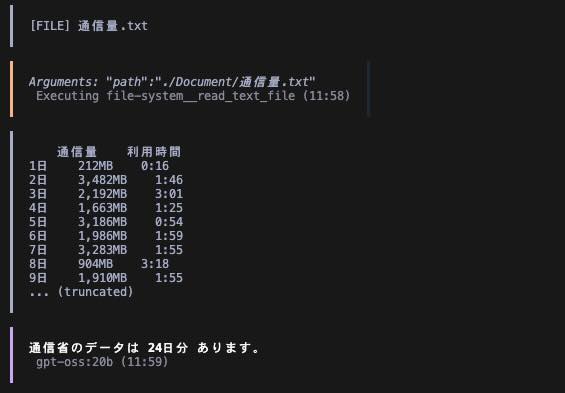

「.mcphost.json」で設定したパスに下記のファイルを配置して、読み取れるか試してみます。

通信量 利用時間

1日 212MB 0:16

2日 3,482MB 1:46

3日 2,192MB 3:01

4日 1,663MB 1:25

5日 3,186MB 0:54

6日 1,986MB 1:59

7日 3,283MB 1:55

8日 904MB 3:18

9日 1,910MB 1:55

10日 1,583MB 1:47

11日 1,127MB 0:00

12日 0MB 0:00

13日 11MB 0:00

14日 1,027MB 1:49

15日 593MB 1:55

16日 2,290MB 1:50

17日 1,807MB 1:01

18日 3,248MB 0:48

19日 713MB 1:55

20日 1,996MB 1:57

21日 789MB 1:50

22日 2,017MB 1:55

23日 5,681MB 0:30

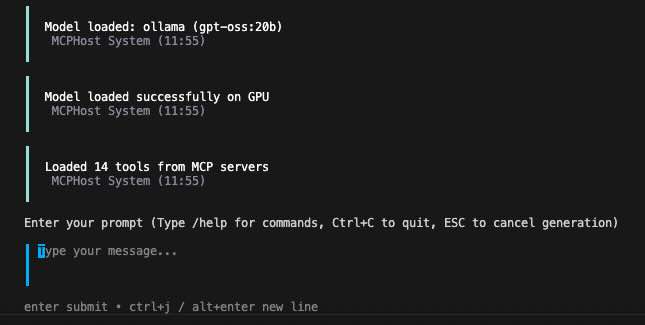

24日 2,798MB 1:42ターミナルからmcphostコマンドで実行します。

※mcphostコマンドが見つからない場合は、/go/binにパスが通っているか確認してみてください。

設定ファイルにモデルは指定しなかったので、引数で設定します。

mcphost -m ollama:gpt-oss:20b

起動したので「通信量には何日分のデータがありますか」とプロンプトを入力してみます。

配置しておいた「通信量.txt」を無事読み取ってくれました。

まとめ

AIを社内で活用する際、最大の課題となるのは「セキュリティとデータの扱い」です。

外部APIを使わずにAIを動かすことで、情報漏えいリスクを避けながら、社内データ活用の可能性を検証できるのがローカルLLM+MCP構成の強みです。

MCPを使えば、AIが社内ファイル・ローカルDB・業務ツールなどを「安全な共通インターフェース」を通じて参照できるようになります。

今回はファイルシステムでしたが、他のデータソースを追加しすることも可能です。

適用範囲を増やしながら、段階的にAIによる社内データ活用を広げていけます。

コメント