AIを業務で活用する際、社内システムや機密データを扱う場合に「クラウドには上げられない」ということがあります。

そんなときの解決策の一つが、ローカルで動作するAI環境です。

また、Difyを使うことでノーコード・ローコードで直感的に作成でき、AIアプリケーション開発の敷居を下げることができます。

今回はWindows環境上にDifyを構築し、Ollamaと連携したAI環境を構築してみたいと思います。

こんな方におすすめ

・社内データをAIに活用したいが、外部クラウドは使えない

・自分のPCでLLMを動かして試してみたい

・DockerやOllamaを活用して安全なAI開発環境を作りたい

環境準備

今回の環境を作るのに必要なソフトです。これらについての導入手順の解説は数多くあるので割愛します。

・Docker Desktop

・Ollama

・Git(任意)

Docker Desktopのインストールについては、Dockerドキュメント日本語化プロジェクト(https://docs.docker.jp/desktop/install/windows-install.html)など、詳細な手順書があるのでそちらを参考にインストールします。

Ollamaについては以前構築した記事を参考にしてもらえればと思います。

Gitについては公式サイトに詳しい説明があります。

Gitをインストールしなくても、ソースをダウンロードして構築することも可能です。

Difyのインストール

Difyにインストーラーは無く、下記のコマンドでGitのDifyリポジトリをクローンします。

※Gitをインストールしていない場合は、https://github.com/langgenius/difyからZipをダウンロードして展開します。

git clone https://github.com/langgenius/dify.gitクローン/展開したディレクトリを起点に、dify/dockerへ移動します。

cd dify/docker「.env.example」という環境配置ファイルをコピーし、ファイル名「.env」で保存します。

copy .env.example .env最後にDockerコマンドでコンテナを起動します。

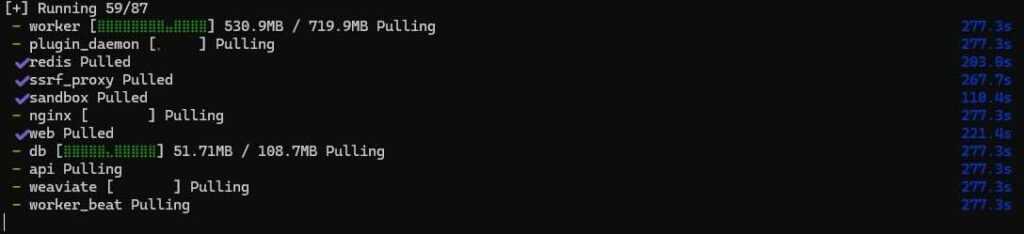

docker compose up -dすると、ダウンロードが始まるので少し待ちます・・・

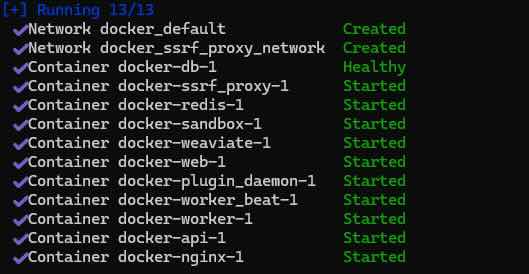

ダウンロードが終わり、コンテナが無事に起動できれば完了です。

Difyの初期設定

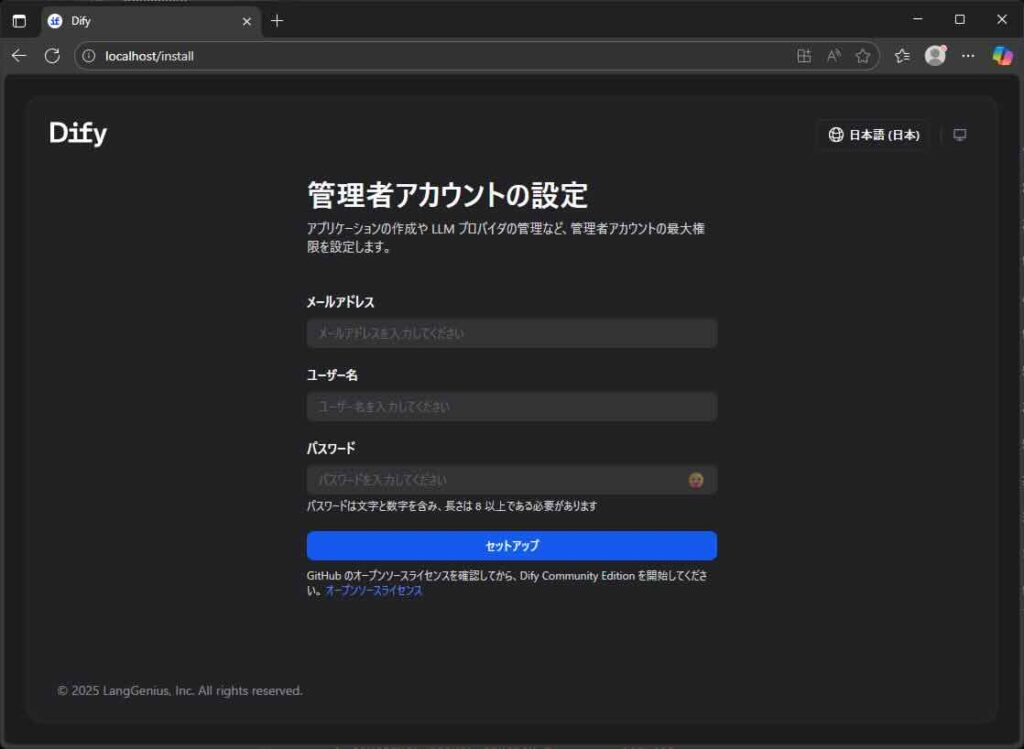

ブラウザで下記のURLにアクセスします。

http://localhost/install

最初に管理者アカウントのセットアップページが表示されるので、メールアドレス・ユーザー名・パスワードを入力して「セットアップ」をクリックします。

アプリページが表示されれば初期設定は完了です。

モデルプロバイダー設定

Difyとローカルに構築したOllamaとを接続するため、モデルプロバイダーの設定を行います。

ページ右上のアカウントアイコンをクリックし、プルダウンメニューから「設定」を選びます。

設定ページが表示され、インストールするモデルプロバイダーが一覧表示されます。

一覧から「Ollama」を選択し、「インストール」をクリックします。

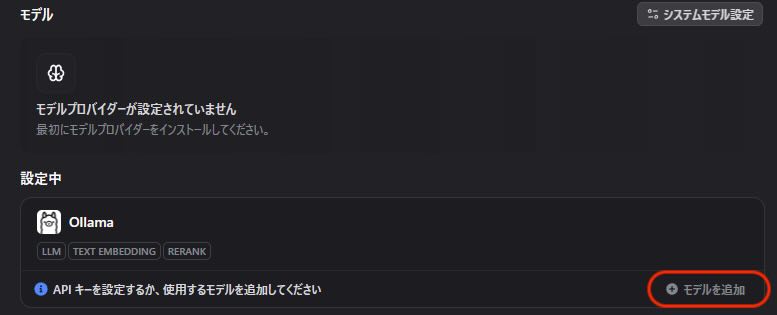

少しすると、インストールしたOllamaが設定中となります。

(インストールをクリックしてから設定中になるまで、数十秒かかりました。表示が切り替わらず、その間もインストールをクリックできてしまうのでご注意ください。)

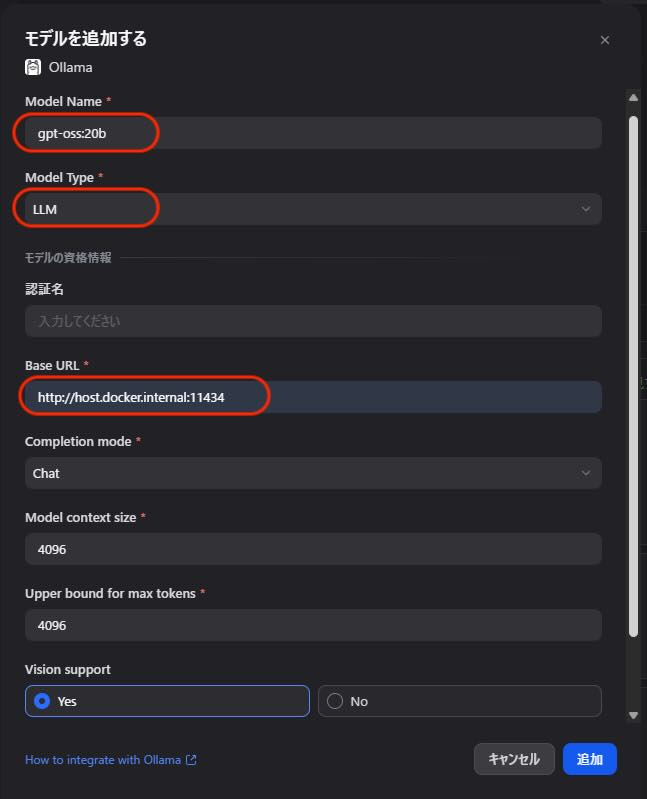

次に、Ollamaで使うLLMのモデル設定を行うため、設定中となったOllamaの右下にある「モデルを追加」をクリックします。

ダイアログが表示されるので、必要な情報を設定して「追加」ボタンをクリックします。

赤枠部分が初期表示から変更した項目になります。今回は下記のように設定しました。

・Model Name: gpt-oss:20b

・Model Type: LLM

・Base URL: http://host.docker.internal:11434

以上でOllamaへの設定は完了です。

これでようやくローカルOllamaを使ったDifyのアプリ構築の準備が整いました。

まとめ

今回はDifyのインストール、Ollamaのプロバイダ設定までを行いました。

主要なモデルプロバイダーも準備されており、インストールもクリックひとつと簡単でしたね。

ひとまずSandboxプランで操作を覚えながら、Difyを活用して行こうと思います。

個人的にはワークフローよりも、モデルプロバイダーやAPI連携が気になるので、今後はこの辺りを先に使ってみたいと思います。

コメント